Interprétation transactionnelle

La reformulation transactionnelle de la mécanique quantique (Transactional Interpretation of Quantum Mechanics : TIQM) est historiquement sinon tout à fait la première, mais du moins la principale lecture du formalisme quantique et des équations d'ondes de Schrödinger et de Dirac, qui cesse de se mélanger dans des échelles d'analyse séparées par plusieurs ordres de grandeur (de l'ordre de cinq ordres de grandeur). Proposée en 1986 par John G. Cramer, et redécouverte indépendamment plusieurs fois, cette lecture demeure à ce jour minoritaire, et traitée avec condescendance par la majorité. Or nombreux sont les faits expérimentaux qui rendaient inéluctable la reformulation transactionnelle de la quantique.

Cette page est à considérer comme une ébauche, à terminer.

Sommaire

- 1 Sources historiques

- 2 Les faits expérimentaux qui rendent la TIQM inéluctable

- 2.1 Détection industrielle du monoxyde de carbone dans l'air

- 2.2 Spectrométrie infrarouge des molécules gazeuses

- 2.3 Efficacité lumineuse des colorants, et méthodes colorimétriques

- 2.4 Expériences de diffractions et interférences sur électrons, atomes, molécules

- 2.5 La modification alentour par une antenne accordée (Yagi-Uda par exemple)

- 3 Etat de la théorisation chez différents auteurs

- 4 Les postulats subreptices que la transactionnelle rejette :

- 5 Références et bibliographie

Sources historiques

Albert Einstein 1916 : Quantentheorie der Strahlung

Deux articles de 1916 sont à considérer :

Strahlungs-emission und -absorption nach der Quantentheorie, paru dans Verhandlungen der Deutschen Physikalischen Gesellschaft, 18, 318–323

Quantentheorie der Strahlung, paru dans Mitteilungen der Physikalischen Gesellschaft, Zürich, 16, 47–62

Republié en 1917 dans Physikalische Zeitschrift, 18, 121–128

Einstein y démontre que le spectre du corps noir tel que démontré théoriquement par Max Planck, et surtout la mécanique statistique des gaz de Clerk Maxwell en présence de rayonnement thermique à l'équilibre, exigent que chaque photon transporte non seulement de l'énergie, mais aussi une quantité de mouvement, dans une direction définie. Il n'y a pas, à l'échelle photonique, de rayonnement isotrope, ni ayant la plus petite approximation en ce sens.

Ce qui ruinait d'avance les idéations ultérieures des copenhaguistes avec "onde de probabilité" dans toutes les directions, mystérieusement suivie après d'une "réduction du paquet d'onde", une confusion systématique entre le phénomène physique et le renseignement que nous animaux macroscopiques, avons sur lui.

A présent que nous avons davantage d'expérience en radio-électricité qu'il n'était d'usage en 1916, on peut préciser à quoi de macroscopique s'opposait la découverte d'Einstein :

En acoustique, l'onde à propagation sphérique est expérimentée à chaque détonation de mine ou grenade sous-marine. Divergente dans ces cas là. A Los Alamos, ils ont eu à synchroniser une onde à propagation sphérique convergente, une implosion, pour amorcer la bombe au plutonium.

En électromagnétisme, l'onde sphérique est impossible : elle violerait les conditions de polarisation (voir le théorème des hérissons : il est impossible de peigner intégralement une sphère). En polarisation rectiligne, telle qu'on l'obtient en vertical avec une antenne fouet, en horizontal avec un seul brin d'une Yagi, le lobe d'émission est toroïdal autour de l'axe d'antenne, compte-non tenu des interférences avec la Terre. Il faut renforcer une direction par plusieurs brins résonnants de Yagi pour obtenir une émission (ou une réception aussi bien) plus directionnelle. Ou câbles verticaux alignés, avec alimentations à déphasages contrôlés, pour de la radiodiffusion vers une cible géographique définie.

En polarisation circulaire, on peut obtenir directement des lobes directionnels mieux définis avec une direction avant et une direction arrière. Cela peut se faire avec un cadre bobiné et une ferrite, ou des déphasages entre brins.

La découverte d'Einstein établissait une différence majeure dans le monde microphysique : il n'y a pas de diffusion isotrope, ni même à direction diffuse. Tout photon a une seule direction, un seul émetteur, un seul destinataire, qui reçoit toute la quantité de mouvement correspondant à l'énergie du photon, prise dans son repère.

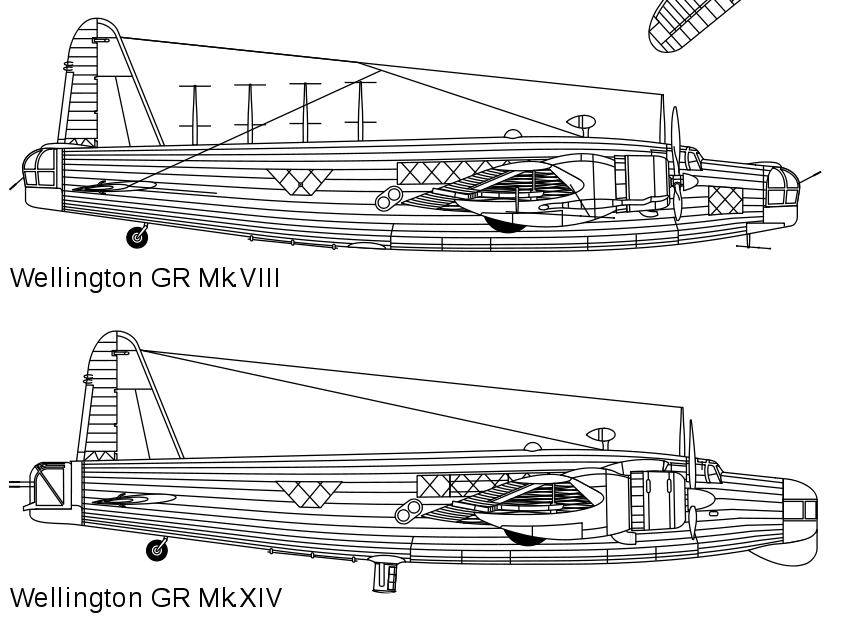

Or nous avons vu plus haut, en étudiant les installations de radiodiffusion telles qu'elles fonctionnent, qu'il faut se donner beaucoup de mal, et occuper pas mal d'espace au sol (plusieurs fois la longueur d'onde), pour réussir à émettre de façon vaguement directionnelle en grandes ondes et en ondes moyennes, voire en ondes courtes aussi. On n'a pu obtenir la directivité voulue en radar qu'en réduisant la longueur d'onde à moins de dix fois le diamètre de l'antenne. Oui à la fin de la seconde guerre mondiale, il y a eu des radars en ondes centimétriques, embarqués sur des avions, mais surtout sur des bimoteurs et quadrimoteurs anti-sous-marins (Sunderlands, Liberators), qui parfois portaient aussi un canon de 75 mm.

La comparaison est éloquente entre deux versions successives du Wellington de patrouille anti-sousmarine, version avec radar métrique ( = 1,7 m), puis en centimétrique, (

= 9,1 cm) :

Bon, alors on fait comment pour obtenir de la directivité à partir d'un atome plus petit qu'un nanomètre, sur une radiation de lumière visible, dont la longueur d'onde est de l'ordre du demi-micromètre, soit mille à deux mille fois plus grand pour la longueur d'onde et un bon million de fois plus grand, pour le photon entier ?

Aussi longtemps qu'on veut obtenir cette directivité depuis l'émetteur tout seul, l'impasse est totale : c'est physiquement impossible. Seule la transaction entre émetteur et absorbeur peut obtenir cette directivité découverte en 1916 par Albert Einstein.

Pourquoi donc les physiciens entre 1916 et à présent n'ont pas été capables de transposer vers la microphysique les connaissances existantes en radio-électricité ? A l'exception de Louis de Broglie, mobilisé à l'émetteur de la tour Eiffel, aucun n'avait travaillé dans le domaine radio-électrique, et les connaissances disponibles ici n'ont pas percolé là...

Louis Victor de Broglie, 1923, 1924

La seconde source historique qui aurait pu être exploitée dès la fin des années vingt, est la thèse de Louis de Broglie de 1924, qui fournissait le mécanisme des "poignées de mains" entre émetteur et absorbeur. Mais aucun physicien américain n'a lu cette thèse, ni Feynman, ni Wheeler, ni Cramer. Elle n'a jamais été traduite en anglais ; seul son discours Nobel... Broglie rassemblait l'hypothèse de Planck et Einstein reliant la fréquence et l'énergie d'un rayonnement : à la relation d'Einstein

,

Ce qui lui donnait la fréquence intrinsèque de tout quanton avec masse : .

Broglie calculait alors comment la cohérence relativiste des observateurs voyant passer cette onde matérielle imposait son théorème d'harmonie des phases, et la relation entre vitesse de phase et vitesse de groupe :

Il en découlait qu'aucune "particule" n'est ponctuelle ni même très petite, mais au minimum d'extension spatiale comparable à son rayon Compton ou à sa longueur d'onde Compton

.

Broglie donnait ainsi la raison ultime réunissant la mécanique et l'optique. William Rowan Hamilton avait déjà donné cette réunification de façon formelle en 1827 (Mécanique hamiltonienne), mais sans pouvoir donner de raison physique au fait que les trajectoires en mécanique sont perpendiculaires aux surfaces iso-action. Louis de Broglie prouvait que ces surfaces iso-action sont aussi isophases, et que la mécanique se ramène au principe de Fermat : tout trajet réel est isophase comparé à ses proches voisins, et aucun trajet réel n'est de largeur ni nulle ni négligeable.

La vitesse de phase infinie dans le repère propre de la particule, implique que toute particule baigne dans le bruit de fond broglien de tous ses voisins, inévitable, non écrantable, et qui échappe à la quasi-totalité de nos moyens d'investigations depuis notre échelle humaine. Cela implique qu'un solide cristallin à température proche du zéro absolu est un milieu où chaque atome est simultanément "informé" de tous les autres. L'hypothèse broglienne implique aussi que dans une expérience d'interférences style fentes d'Young, tout électron n'interfère qu'avec lui-même, car aucun autre n'est assez en accord ni de fréquence, ni de phase, ni de direction (sans même parler du spin, peu connu en 1924) pour maintenir l'interférence le temps d'un trajet. L'optique électronique est nécessairement de l'optique incohérente, alors qu'avec de la lumière, on sait faire des sources cohérentes multiphotons.

P.A.M. Dirac, J. A. Wheeler, R. Feynman

La troisième source historique, et qui a été exploitée, elle, fut de remarquer qu'aucune raison, ni microphysique ni expérimentale, n'interdisait les solutions à ondes avancées, ni en électromagnétisme, ni en équation de Schrödinger ou de Dirac. Le premier à explorer cette voie, fut P.A.M. Dirac, en 1938. Dirac était le mieux placé pour remarquer que les solutions de son équation de 1928 pour l'électron, ont deux composantes à pulsation orthochrone, et deux composantes à pulsation rétrochrone (à rebours du temps macroscopique usuel). Pour tout électron, les parties orthochrones et les parties rétrochrones sont indissolublement liées.

Dirac fut suivi par Richard Feynman et John Archibald Wheeler en 1945 (qui sont cités dans l'article original de John Cramer). Cela leur a permis de résoudre le problème de la masse électromagnétique de l'électron. Cramer a repris l'idée des deux ondes pour son interprétation transactionnelle de la théorie quantique.

L'interprétation transactionnelle tient compte du palpage permanent de l'entourage de chaque quanton ayant une masse, par ses ondes brogliennes, à la fréquence intrinsèque mc²/h. Rappelons que leur vitesse de phase V est égale à c²/v, où v est la vitesse de groupe; elle est donc infinie dans le repère propre de tout quanton avec masse - au moins en l'état actuel de nos connaissances, mais cela mériterait d'être réexaminé plus finement dans le cadre local de l'équation de Dirac. Ce bruit de fond broglien est inévitable, non écrantable, et par les fréquences mises en jeu, échappe à la quasi-totalité des moyens d'expérimentation. Ce bruit de fond permanent résout le mystère de la connaissance magique de l'environnement par les "particules" du mythe à-la-Copenhague. Sur ce bruit de fond broglien permanent, peuvent s'amorcer de nombreuses poignées de mains, qui en large majorité n'aboutissent pas. Si l'une d'entre elles aboutit, par exemple au transfert d'un photon, il s'établit alors un court état stationnaire de transfert synchrone : durant le transfert, émetteur et absorbeur sont couplés, simultanément par ondes avancées et par ondes retardées, en fréquence, en phase et en polarité, jusqu'à ce que chacun arrive au nouvel état stationnaire, qui lui aussi est un état propre, déterminé par des conditions de résonance stationnaire, liée au même quantum d'action de Planck. Les deux correspondants décrochent alors, c'est la fin du transfert du quantum d'action, le bruit de fond reprend tous ses droits localement sur chacun. Erwin Schrödinger avait fourni le mécanisme en 1926, par battement de l'électron entre la fréquence de l'orbitale initiale et celle de l'orbitale finale, mais n'avait pensé qu'à l'émission, pas à l'absorption : il avait pensé à l'émetteur superhétérodyne, pas au récepteur superhétérodyne, alors que ces récepteurs sont devenus ensuite la technologie courante en radio, même en télévision. De plus, s'étant découragé de traiter l'électron de façon relativiste, alors que c'était la base même de la thèse de Louis de Broglie, il ne disposait plus de l'origine des énergies, ni bien sûr de la valeur des fréquences brogliennes (intrinsèques) des orbitales. Cette malencontreuse incohérence a encouragé le clan opposé (et majoritaire), à savoir Bohr et vassaux et alliés, à occulter cette partie là de son article, qu'aucun enseignant ne mentionne jamais.

Les faits expérimentaux qui rendent la TIQM inéluctable

Détection industrielle du monoxyde de carbone dans l'air

Rappel préalable :

La transparence de l'air à la plupart des rayonnements électromagnétiques est incompatible avec le modèle des photons corpusculaires, et avec le modèle de la section géométrique comme section de capture.

Le monoxyde de carbone est une molécule dissymétrique, où les deux atomes ont des affinités électroniques différentes. Elle est donc couplée au rayonnement électromagnétique dans ses déformations en élongation-compression. La fréquence de résonance est de 64,25 Terahertz, pour une longueur d'onde dans l'air ou le vide de 4,666 µm. Nombreux sont les détecteurs industriels qui peuvent surveiller l'air d'une usine, voire surveiller la pollution industrielle à l'échelle du continent européen par reconnaissances aériennes, qui sont basés sur cette absorption spectrale spécifique.

Or cette molécule est de très petite taille, comparée au rayonnement dont elle peut avaler les photons. L'atome le plus large est l'oxygène, large d'environ 3,2 ångströms. la liaison est longue de 1,11 ångströms, soit un grand axe d'environ 4,3 ångströms, et une section transversale d'environ 10 à 12 Å2. Or ce couplage possible avec le rayonnement I.R. est fortement gêné par des désaccords en gyration de la molécule, dans le domaine des fréquences en micro-ondes.

La section efficace de capture n'est pas sans commune mesure avec la section géométrique de ces rares molécules dans beaucoup de vide et d'autres molécules, et qui aient la bonne orientation géométrique, d'une atmosphère courante, sauf que ce mode de raisonnement est invalidé par la transparence de l'air au visible et à l'infrarouge, sauf justement les quelques fréquences compatibles avec une résonance d'une molécule bien particulière.

Et à coup sûr ça marche, les détecteurs fonctionnent à la satisfaction générale...

La précision annoncée est de l'ordre de 5 ppbV pour un appareil commercial Model 48CTL utilisé dans le programme de mesures atmosphériques MOZAIC. Adresse : http://www.atmos-chem-phys-discuss.net/3/3713/2003/acpd-3-3713-2003-print.pdf .

La seule explication possible est que si l'onde électromagnétique a la bonne fréquence, alors elle converge vers la molécule résonante. Les conditions finales sont bel et bien vues par l'unité de radiation électromagnétique qu'est le photon. En fac, nous avions tous étudié l'émission d'une onde selon une symétrie sphérique, mais jamais la convergence d'une onde selon la même géométrie, décriée par le professeur comme impossible et absurde. La réalité physique se révèle bien différente de ce qui est professé. La symétrie n'est jamais sphérique. Du reste le théorème des hérissons l'interdit pour toute onde transverse telle qu'une onde électromagnétique : il est impossible de peigner intégralement la surface d'une sphère. Albert Einstein l'avait aussi démontré en 1916 (Zürich), publié en 1917 à Berlin : l'émission de photons est nécessairement dirigée, sinon la distribution maxwellienne des vitesses dans un gaz serait vite détruite par les échanges de photons.

L'onde est bien émise vers un absorbeur, et captée depuis un émetteur. La description orthochrone et à énergie positive depuis l'émetteur, seule enseignée partout, est indissoluble de la capture par l'absorbeur, ou autrement dit de l'émission d'un photon rétrochrone, d'énergie négative et de fréquence négative, par l'absorbeur : c'est une seule et même transaction.

Spectrométrie infrarouge des molécules gazeuses

La même contrainte s'applique à toute la spectrométrie infrarouge et micro-ondes dans les gaz : bandes d'absorption des molécules O3, CO2, H2O, CH4, etc.

Dans le domaine des résonances par gyration, où les fréquences sont du domaine des micro-ondes, l'écart entre la dimension de la molécule absorbante et les dimensions minimales du photon, est encore plus énorme.

Efficacité lumineuse des colorants, et méthodes colorimétriques

Toutes les molécules de colorants organiques, chlorophylle inclusivement, sont de taille modérée, typiquement de 4 à 15 ångströms entre les extrémités de la résonance de l'électron délocalisé. Et pourtant, dans un objet coloré par des tels colorants organiques, qu'il soit un polymère industriel coloré, ou une feuille végétale, c'est bien la quasi-totalité d'une fréquence du spectre, qui est absorbée spécifiquement. Même en tenant compte de la profondeur de pénétration de la lumière dans la plupart des polymères, synthétiques ou organiques (végétaux pour la plupart, mais la règle est la même pour les polymères de synthèse animale), la section efficace de capture par les colorants excède nettement leur section géométrique.

La colorimétrie en phase liquide est très employée comme méthode de dosage chimique. Là encore, le besoin est manifeste d'une théorie cohérente de la section de capture des colorants. Les slogans hâtifs de l'idéation à-la-Copenhague sont bien loin de remplir le cahier des charges.

Une autre tâche encore à accomplir, consiste à faire la théorie de la concentration de l'onde lumineuse de la fréquence résonante, vers les centres F (F pour Farbe) dans les minéraux colorés, par exemple les micas noirs genre biotite. Alors que la réflexion sur les minéraux lisses (telle que sur les plans d'automorphie d'un quartz, ou sur le plan basal d'un mica muscovite) n'implique aucune concentration du photon, qui peut rester délocalisé en diamètre. Puis de valider expérimentalement cette théorisation.

Expériences de diffractions et interférences sur électrons, atomes, molécules

Pour toute expérience d'interférence sur particules dotées de masse, en pratique tous des fermions, dont les plus célèbres sont celles réalisées sur spécification d'Aharanov et Bohm sur des électrons, chaque fermion ne peut interférer qu'avec lui même : il n'existe pas d'émetteur cohérent de fermions. Chaque fermion passe donc simultanément par plusieurs branches de trajet, deux branches pour une expérience par fentes ou trous d'Young, bien davantage de branches distinctes dans une interférence sur réseau, réseau artificiel, ou réseau cristallin. L'idéation corpusculariste, même réduite à l'acrobatie mentale des "aspects corpusculaires" est par trop incompatible avec la réalité expérimentale.

L'idéation corpusculariste, inaugurée en 1905 par Albert Einstein, n'est due qu'au postulat subreptice et superflu "Il n'y a pas d'absorbeurs". Ce postulat subreptice et superflu est incompatible avec de larges classes de faits expérimentaux, dont justement les interférences, ainsi que les diffractions sur réseaux cristallins, qui ont fondé toute la radiocristallographie.

Le paradoxe nègre-blanc qui caractérisait l'idéation à-la-Copenhague, où les quantons devaient être soit à la fois, soit tour à tour corpuscules et ondes, est remplacé par un autre défi, qui est incontournable : c'est notre espace-temps, qui à l'échelle quantique ne retrouve aucune des propriétés familières qu'on lui connaît à l'échelle macroscopique. Cette théorie de l'émergence de notre espace-temps macroscopique à partir des interactions élémentaires a été ébauchée par Roger Penrose en 1971, mais il reste encore beaucoup de travail à accomplir.

La modification alentour par une antenne accordée (Yagi-Uda par exemple)

Il est bien connu de tous les radio-amateurs, et de tous les poseurs d'antennes, qu'une antenne accordée déjà présente, notamment avec les antennes Yagi-Uda qui abondaient sur les toits des villes avant la généralisation du câble, modifie la répartition du champ alentour d'elle, en intensité en en direction : elle pince et concentre le champ autour d'elle, et sa section de capture en énergie est nettement supérieure à sa section géométrique. Chaque nouvelle antenne posée modifie le champ des voisines, et oblige éventuellement de monter sur le toit pour corriger l'orientation. La première antenne posée visait bien l'émetteur en ligne droite. Mais il y a toujours des cas de réception inespérée au fond d'une cour encaissée, avec une orientation et en un emplacement largement imprévisibles.

Voilà des faits incompatibles avec l'idéation corpusculariste, et l'artillerie de corpuscules.

Ah oui, mais ni les poseurs d'antennes, ni les radio-amateurs n'écrivent dans des revues théoriques à comité de lecture académique...

Etat de la théorisation chez différents auteurs

Etat de la théorie chez John Cramer

... elle décrit tout évènement quantique comme étant une « poignée de main » entre l’onde avancée et l’onde retardée. Cette interprétation a été proposée pour la première fois par John Cramer en 1986. Il indique que cette façon de voir les choses est plus intuitive, évite le problème folklorique du rôle de l'observateur dans l'interprétation de Copenhague, et résout divers paradoxes quantiques <ref>The Transactional Interpretation of Quantum Mechanics by John Cramer. Reviews of Modern Physics 58, 647-688, July (1986)</ref> <ref>An Overview of the Transactional Interpretation by John Cramer. International Journal of Theoretical Physics 27, 227 (1988)</ref>. Cramer utilise l'interprétation transactionnelle dans son cours de mécanique quantique à l'université de Washington à Seattle.

(ici morceau d'héritage incohérent, à redévelopper très différemment : "Supposons une expérience similaire aux fentes d'Young où l'on installe deux détecteurs pour déterminer par quelle fente est passée la particule (un photon par exemple) qui a été émise par une source .")

Selon la version Cramer de la TIQM, la source émet une onde conventionnelle (retardée) ; l'"onde de reconnaissance, ou de demande d'émission", quand cette onde atteint les absorbeurs (mais quand c'est un tenant de la mythologie dominante qui rédige, il remplace "absorbeur", qui est un terme objectif, par celui de "détecteur", qui appartient aux intentions d'un expérimentateur... anthropocentrisme hégémonique !), chacun répond avec onde avancée, l'"onde de confirmation", qui remonte le temps, en retournant vers la source. Les phases des ondes de reconnaissance et de confirmation sont corrélées de telle manière qu'elles interfèrent positivement pour former une onde de pleine amplitude dans la région de l'espace-temps située entre le moment de l'émission et celui de l'absorption ("la détection" en mythologie anthropocentrique hégémonique). A l'inverse, ces ondes s'annulent partout ailleurs dans l'espace-temps (c'est-à-dire avant l'émission et après l'absorption). Si l'on sait l'émetteur (ce qui n'est vrai qu'à l'échelle macroscopique, jamais à l'échelle individuelle), alors la probabilité avec laquelle la particule émise se concentrera sur tel absorbeur plutôt que tel autre reste calculable par les mêmes moyens que précédemment : conformément au postulat positiviste du groupuscule qui en est l'auteur, ils n'ont été élaborés que pour répondre à cette seule question, comme si cette seule question épuisait la physique. Aucune équation n'a été modifiée entre avant et après la TIQM, mais en TIQM, on tient compte des conditions finales, ce qui était interdit avant, et tenu pour hérétique.

On peut objecter que le schéma causal publié par Cramer demeure à demi folklorique, avec une activation de l'absorbeur par l'initiative de l'émetteur. Cramer n'a pas soulevé la question de la malédiction des Emetteurs chauds et évidents, absorbeurs discrets et incontrôlables. Malédiction du point de vue de la communauté des physiciens, mais qui est thermodynamiquement inévitable.

En particulier, il y a généralement mystère sur la fréquence, la phase et la polarisation de l'onde rétrochrone, demanderesse de particule. Le cas est limpide pour l'absorption de photon infrarouge par une molécule de gaz (triatomique ou davantage, ou diatomique dissymétrique) sur une de ses fréquences propres de déformation, mais de nombreux cas physiques sont bien moins documentés. Le cas des photons et des neutrinos qui "voyagent" quelques milliards d'années dans l'espace intergalactique sans rencontrer encore d'absorbeurs, pose un problème affectif et narcissique aux physiciens : comment raisonner sur des conditions finales dont nous ignorons tout, ni même si elles pourraient exister ? Le problème de la seconde quantification, ou quantification des champs, et de la nécessaire non-localité de l'espace qu'elle implique sur toute l'étendue de cohérence d'un photon, d'un neutrino, ou de tout autre quanton, n'est pas abordé par Cramer.

Dans cette interprétation, le mythique effondrement de la fonction d'onde est un faux problème. Le phénomène physique est la transaction. La physique objective se déroule entre un absorbeur physique réel et un émetteur physique réel, mais cela ne fait pas nos affaires anthropocentriques : en bons égoïstes, pas encore dégagés de nos fantasmes infantiles de toute-puissance, nous préférerions que tout cela nous obéisse... Cette déception furieuse s'est manifestée par la mythologie, actuellement hégémonique, d'une cruelle incertitude de Heisenberg. La physique objective n'est pas indéterministe ni statistique dans son principe, mais c'est l'usage macroscopique que nous, êtres macroscopiques, nous pouvons en faire, qui est nécessairement statistique. Tel est le fardeau de la condition humaine : nous sommes de gros assemblages macroscopiques, nous, et le Théorème de la Variété Nécessaire d'Ashby pose des bornes infranchissables à nos fantasmes panoptiques ("Si si ! On va tout savoir si on sait parfaitement les conditions initiales, et les conditions initiales, on les saura ! ...").

John Cramer a expliqué que l'interprétation transactionnelle est conforme aux résultats de l'expérience de Marlan Scully, alors que l'interprétation de Copenhague et l'interprétation des mondes multiples ne le sont pas.<ref>A Farewell to Copenhagen?, by John Cramer. Analog, December 2005.</ref>

Lettre de Cramer sur la réception de la TIQM

Autres auteurs indépendants

Les progrès encore nécessaires

A certains égards, la reformulation TIQM semble bien rendre non nécessaire la quantification du champ dans l'espace, ou seconde quantification, puisque l'émetteur aussi bien que le récepteur seraient tous deux soumis à des conditions de stationnarité, qui leur imposent que chaque transaction ne mette en jeu qu'un quantum d'action h exactement, par exemple pour un changement d'orbitale d'un électron.

Cette élimination repose sur des bases incomplètes. Et notamment, elle défaille à rendre compte du cas historique et fondateur (Max Planck, décembre 1900) : la densité en photons dans une cavité représentant le corps noir. De plus, nombreux sont les autres cas expérimentaux, à fréquences peu clairement définies, par exemple l'émission de lumière Cerenkov, où la contrainte d'onde stationnaire de l'émetteur ou de l'absorbeur, n'est pas aussi évidente que pour les cas historiques qui avaient attiré l'attention des spectroscopistes.

La TIQM est une théorie à deux partenaires seulement : l'émetteur et l'absorbeur.

La théorie de Bohr, alliés et vassaux, est aussi une théorie à deux partenaires : l'émetteur et l'espace.

Une théorie à trois partenaires, l'émetteur, l'absorbeur, et l'espace, est nécessaire. Formellement, la QED est dans ce cas, encore que la clarification préalable de ses concepts peut être tenue pour inachevée.

Le problème était déjà présent lors de la première formulation de la théorie de l'absorbeur par Wheeler et Feynman : ils trouvèrent que la masse de l'électron était entièrement attribuable à son couplage électromagnétique avec le restant des autres charges dans l'Univers, moitié par ondes retardés, moitié par ondes avancées. Or n'ayant à cette époque (1940) aucune connaissance de la thèse originale de Louis de Broglie, mais juste ce que la rumeur de bouche à oreille leur avait transmis, ils n'avaient fait aucune formulation fréquentielle de ce couplage serré avec le restant de l'Univers. Et le mystère reste entier pour l'origine de la masse supplémentaire des deux électrons lourds, le muon et le tauon.

Les postulats subreptices que la transactionnelle rejette :

Les postulats anthropocentristes sont légions dans la vulgate hégémonique, héritée de la tradition à-la-Copenhague :

Liste plus complète sur cette page : Microphysique : ondulatoire ou poltergeist ?.

Ils mettent l'observateur macroscopique au centre de l'image, et sa volonté, et sa conscience, et son information, et son ignorance, et son incertitude...

Voici l'exemple d'un énoncé classique, qui n'est plus admis après abandon des postulats anthropocentristes et anti-transactionnels :

On utilise souvent le terme de "fonction d'onde", y (x) qui est une quantité qui varie avec la position (parfois aussi avec le temps), comme q(x) plus haut. Elle décrit l'état y d'une particule (ou d'un système plus complexe). La fonction d'onde est une amplitude et c'est simplement une notation raccourcie pour xy . ... C'est une fonction qui donne l'amplitude de trouver la particule en chaque point x .

Il y a là confusion entre l'état d'ignorance de l'observateur macroscopique sur une idée de "particule" (avec cette idée follement corpusculariste de "trouver la particule"), et les lois physiques objectives sur ce qui se propage, ce qui évolue, etc. et qui est bien ondulatoire et se décrit bien avec des fonctions ondulatoires.

Par chance pour la théorie copenhaguiste, dans les deux cas les lois d'évolution sont les mêmes, ce qui fait que leur théorie macroscopo-centrée donnait quand même de bons résultats : le hasard a fait que le formalisme était quand même correct, lui, si la sémantique était aussi fautive et délirante que possible. En revanche les conditions aux limites divergent entre les deux théories. Et entre les deux, il y a toujours la malédiction des astronomes et des phares : Emetteurs chauds et évidents, absorbeurs discrets et incontrôlables.

Faits expérimentaux incompatibles avec l'artillerie de corpuscules

Liste de postulats hérités du copenhaguisme, et qu'on n'admet plus en TIQM.

Postulat anti-Broglie, anti-Schrödinger :

Négation obligatoire de tous phénomènes fréquentiels autres qu'électromagnétiques et sans masse. Négation des fréquences intrinsèques de particules avec masse.

Postulat géométrique macroscopique :

Autosimilitude de l'espace et du temps à toutes échelles, avec extrapolation illimitée, et extrapolation vers la microphysique de l'irréversibilité statistique du temps macrophysique, et extrapolation de la topologie à finesse infinie héritée des mathématiciens du 19e siècle.

Corollaire 1, de "quelque chose de très petit" :

Postulat qu'on peut toujours trouver plus petit permettant de définir qu'un truc, un électron par exemple, est "petit", corpusculaire, voire "ponctuel".

Corollaire 2, anti-absorbeurs :

Il n'y a pas d'absorbeurs en microphysique, juste de l'artillerie de corpuscules, tout comme en macrophysique.

Postulat positiviste à géométrie variable et opportuniste :

Appel systématique aux dimensions de la macrophysique, avec son "observateur", pour régir les réalités microphysiques.

Corollaire anti-Fourier :

Les coups de la "dualité" et de la cruelle incertitude de Heisenberg pour dissimuler les propriétés de la transformation de Fourier à l'échelle microphysique.

Postulat anti-ondulatoire :

Même quand on la calcule et que les chimistes s'en servent quotidiennement avec succès, l'onde de Schrödinger demeure fictive, dépourvue de tout sens physique, et ne sert qu'à calculer la probabilité d'apparition du corpuscule farfadique et poltergeist. Lequel est autorisé à aller explorer jusqu'au delà de la planète Jupiter dans son trajet entre le canon à électrons et l'écran cathodique ou le circuit intégré en gravure. D'ailleurs Feynman et Hawking l'ont écrit, alors...

J'en ai oublié ?

Les compromis diplomatiques dangereux

Par prudence diplomatique, Cramer persiste à utiliser les expressions folkloriques "réduction du paquet d'ondes", et "réduction du vecteur d'état", alors que ces expressions sont dépourvues et de sens et d'utilité en TIQM.

Rédaction encore en cours. A suivre.

Références et bibliographie

Références

1. Dirac, P. A. M., 1938, Proc. Royal Soc. London A167, 148.

2. J. Chem. Educ. 1979, 56, 631-634, en ligne sur Journal of Chemical Education : How a Photon Is Created or Absorbed (lien mort depuis, hélas) :

by : Giles Henderson, Eastern Illinois University, Charleston, IL 61920

Robert C. Rittenhouse, Walla Walla College, College Place, WA 99324

John C. Wright and Jon L. Holmes, University of Wisconsin-Madison, Madison, WI 53706.

3. C. F. Bohren, "How can a particle absorb more than the light incident on it?", Am J Phys, 51 #4, pp 323 Apr 1983

4. H. Paul and R. Fischer "Light Absorption by a dipole", SOV. PHYS. USP., 26(10) Oct. 1983 pp 923-926

5. The Transactional Interpretation of Quantum Mechanics [archive] by John Cramer. Reviews of Modern Physics 58, 647-688, July (1986)

6. An Overview of the Transactional Interpretation [archive] by John Cramer. International Journal of Theoretical Physics 27, 227 (1988)

7. A Farewell to Copenhagen? [archive], by John Cramer. Analog, December 2005.

8. Roger Penrose. Angular Momentum : an Approach to Combinatorial Space-Time. pp 151 - 180, in Quantum Theory and Beyond. Edited by T. Bastin. Cambridge University Press, 1971.

9. Wheeler, John Archibald and Feynman, Richard Phillips (1945) Interaction with the absorber as the mechanism of radiation. Reviews of Modern Physics, 17 (2-3). pp. 157-181. ISSN 0034-6861 http://resolver.caltech.edu/CaltechAUTHORS:WHErmp45

Bibliographie

- Tim Maudlin, Quantum Non-Locality and Relativity, Blackwell Publishers 2002, ISBN 0-631-23220-6 (expérience destinée à réfuter l'ITMQ)

Liens externes

- John G. Cramer, A transactional Analysis of Interaction Free Measurements, (arXiv) 26 mai 2006

- Pavel V. Kurakin, George G. Malinetskii, Comment l'étude des abeilles peut expliquer les paradoxes quantiques, (Automates Intelligents) 2 février 2005

- Ruth E. Kastner, Cramer's Transactional Interpretation and Causal Loop Problems (quant-ph/0408109), un essai pour réfuter la réfutation de Maudlin